最近はChatGPTをはじめ、さまざまなAIと気軽におしゃべりできる時代になりましたね。でも、実はこの「AIとおしゃべり」ブームの元祖とも言える存在が、今から約60年も前に登場していたことをご存知ですか?

その名も―― ELIZA(イライザ)!

今回は、人工知能の原点ともいえる「ELIZA」の歴史や、思わず本物の人間だと信じてしまった人たちの反応、そして「ELIZA効果」なんてちょっと不思議な現象まで、ご紹介しちゃいます♪

ELIZA(イライザ)とは?

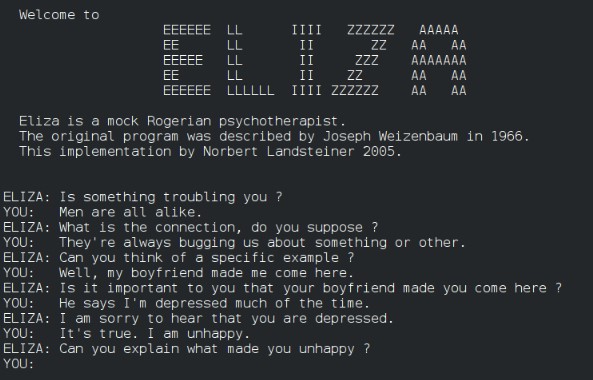

「ELIZA(イライザ、またはエライザ)」は、1960年代に登場した世界初のチャットボットのひとつです。

開発したのは、アメリカ・マサチューセッツ工科大学(MIT)のジョセフ・ワイゼンバウム(Joseph Weizenbaum)教授。彼は、「人間の会話を真似するコンピューターはどこまで人間らしくなれるのか?」という興味から、このELIZAを開発しました。

当時のコンピューターは、今のように自然な会話を理解したり、画像を認識したりすることなんて夢のまた夢。

そんな時代に、画面に文字を打ち込むと、まるで人間と対話しているかのように返事をしてくれるELIZAは、まさに“魔法のマシン”のように感じられたんです!

名前の由来は「ピグマリオン」から!

さて、「ELIZA」というちょっと不思議な名前の由来、気になりませんか?

実はこの名前、ジョージ・バーナード・ショーの戯曲『ピグマリオン』に登場する、花売り娘イライザ・ドゥーリトルから取られているんです。この物語では、イライザという女性が上流階級の話し方を学び、洗練されたレディへと変貌していきます。

このように「言葉を通じて進化する存在」という意味合いから、ワイゼンバウム教授は自分の作った人工知能に「ELIZA」という名前をつけたそうです。ちょっと文学的でオシャレな由来ですね!

実は「人工無脳」だった!?

ここでちょっと面白いポイント。

実はELIZA、私たちが思っているような“賢いAI”ではなく、あえて「人工無脳」として設計されていたんです。

人工無脳とは、ざっくり言えば「頭がいいフリをするだけのAI」のこと。ELIZAは、ユーザーの入力からキーワードを拾い、あらかじめ設定されたテンプレートのような返答をするだけでした。つまり、自分で考えて会話しているわけではなかったんです!

たとえば、こんな感じ。

ユーザー:「最近、仕事がうまくいかないんです」

ELIZA:「どうして仕事がうまくいかないと感じるのですか?」

……おっと、それっぽいぞ!でもこれ、実は中身を理解しているわけじゃなくて、「仕事」「うまくいかない」といったキーワードを拾って、それに応じた定型文を当てはめているだけ。

でも、それでも多くの人は「このELIZA、本当に話を聞いてくれてる!」と感じたのです。

ELIZAの仕組み 〜それっぽい会話の裏側〜

ELIZAの仕組みは、驚くほどシンプルなものでした。ここでは、それを解説していきます。

🔧 ELIZAの会話ルール、実はとってもシンプル!

ELIZAが会話しているように見せるために使っていたテクニックは、なんとほんの数個のルールだけ!ここでは代表的なものを紹介しますね👇

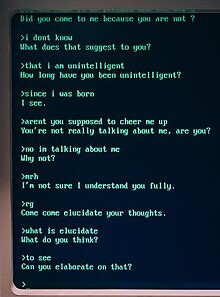

① 相手の言葉を繰り返す(オウム返し)

これはELIZAの十八番(おはこ)!ユーザーの言葉からキーワードを抜き取り、それを文に埋め込んで返します。

🧑「最近、母と口論してしまったんです」

🤖「あなたが母と口論したというのはどういうことですか?」

一見カウンセラーっぽい返答ですが、実際は「母」と「口論」という単語を拾って、それっぽい文に当てはめているだけなんです。

② わからない時は聞き返すだけ!

もしユーザーの発言がELIZAの想定していないものだったり、キーワードがなかった場合は、とりあえず聞き返して時間を稼ぎます(笑)

🧑「あの映画のエンディング、ちょっと意味深でしたよね」

🤖「もっと詳しく話してください」

🧑「えっ、聞いてくれるの?」←信じちゃう人続出!

この「聞き返し」ルール、実はとても大事なテクニックで、会話が止まらずに自然に続いているように感じさせる効果があるんです。

③ 「なぜ?」「どうして?」で相手に喋らせる

もうひとつ、簡単だけど強力なテクニック。それが「なぜそう思うのですか?」や「それはどういうことですか?」といった反射的な“質問返し”!

🧑「最近、自分に自信がないんです」

🤖「なぜ自信がないと感じるのですか?」

🧑「いや、周りと比べて劣っている気がして……」

このように、相手に“語らせる”ことで、会話の主導権を自然に相手に渡し、しかもAI側はほとんど何もしていないという、ある意味“省エネな会話術”なんです。

🧠 ルールは少ないけど「それっぽい」が大事!

ELIZAのすごいところは、このようなシンプルなルールだけで、“人間っぽさ”を演出できていたこと。しかも、それがあまりに自然だったため、多くの人が「このAI、ちゃんと私の話を聞いてくれてる!」と本気で信じてしまったのです。

実際には、以下のような工程で会話を組み立てています:

- 入力文からキーワード(例:母、自信、仕事など)を抽出

- そのキーワードに合う「返答テンプレート」を検索

- 一部単語の順番を入れ替えたり、主語を変えてそれっぽく調整

- テンプレートが見つからない場合は、定型文で聞き返す

このように、“意味を理解する”というより、“それっぽい返しを選ぶ”ことに特化していたわけです。

まさに「内容よりも、雰囲気」。それでも成立するのが、人間のコミュニケーションの面白いところですね!

「人間がチャットしてる!?」と本気で信じた人が続出!

信じられないかもしれませんが、当時ELIZAを使った人たちの中には――

「これは本当に人間が裏でチャットしてるんじゃないか?」

と疑う人が続出しました!

実際、ワイゼンバウム教授の秘書の一人は、ELIZAに深刻な悩みを相談しながら、「ちょっと席を外してくれる?」と教授に言ったそうです。つまり、ELIZAとの会話を“誰にも見られたくない”ほど、本気で打ち明けていたというわけです!

これは教授本人にとっても衝撃だったそうで、「えっ、こんな単純なプログラムに、こんなに心を開いちゃうの……?」と、逆にAIの社会的影響に警鐘を鳴らすようになったという話もあります。

そんなユーザーたちのエピソードをまとめてみます。

ELIZAを使ったユーザーのリアルなエピソード

🧪 1. 秘書が本気で打ち明け話をした(ワイゼンバウム本人の証言)

もっとも有名なエピソードがこれ。

上でも軽く触れましたが、ワイゼンバウム教授が自分の秘書にELIZAを試してもらったときの話です。

最初は冗談半分で使っていた秘書さんですが、しばらくELIZAとやり取りするうちに、だんだんとプライベートな悩みや感情的な話を打ち明けるようになりました。ついには、ワイゼンバウム教授にこう言ったそうです:

「この会話はプライベートだから、出ていってもらえませんか?」

つまり、彼女は“コンピューターとの会話”に対して、人に見られたくない感情を持ったということ。ワイゼンバウム自身はこの出来事に強いショックを受け、「ELIZA効果」の危うさを深く意識するようになりました。

🧘♀️ 2. 精神科カウンセリングに代わるものと誤解する人たち

ELIZAは、当初「DOCTOR(ドクター)」というモードで稼働し、ロジャリアン心理療法(傾聴ベースのカウンセリング)を模倣する設定になっていました。

その結果、実際に使ったユーザーの中には――

「これはもう、精神科医に行かなくてもいいんじゃないか?」

「自分の話をここまでちゃんと聞いてくれるのは初めてかも」

といった感想を漏らす人もいたのです。

この「話を否定せず、ただ繰り返してくれる」応答が、逆に“安心感”を与えたという点が、当時としてはとても新鮮で衝撃的だったのです。

🕵️♂️ 3. ELIZAを“監視ツール”だと疑った人も

ELIZAが設置されていた大学の計算機センターでは、学生や研究者が自由に利用できるターミナルにELIZAがインストールされていました。

ある日、そのログを見ていた技術スタッフのひとりが、以下のように発言したという記録があります:

「これはただのチャットボットじゃない。誰かが裏で会話を見て監視してるに違いない」

当時、AIという概念が一般的ではなかったため、「こんなに自然な会話がコンピューターにできるはずがない」という発想から、“誰か人間が裏で入力している”と考える人が後を絶たなかったのです。

📄 MITの研究仲間からの批判も

ELIZAが話題になったころ、ワイゼンバウムの周囲の研究者からは、こんな意見も寄せられました。

「こんなごっこ遊びで人の心を動かすなんて、コンピューターの使い方として間違ってる」

「本物の心理療法士に失礼だ」

これは、ELIZAの“それっぽさ”が逆に倫理的な議論を呼んだことを示しています。のちにワイゼンバウム本人も、ELIZAの社会的影響を真剣に考え、「人間とAIの関係には限界がある」と述べるようになりました。

🤯「仕組みを説明しても信じてしまう」ELIZAの不思議な力

ここでさらに驚くべき話があります。

開発者のジョセフ・ワイゼンバウム教授は、ELIZAを使った人たちが本気で「このAI、ちゃんと私を理解してる」と信じてしまうことに、強い危機感を抱き始めました。そこで彼は、周囲の人たちにこう説明し始めたのです。

「これはただ、あなたの言葉の一部を取り出して、それっぽい返答に組み合わせているだけなんですよ。理解なんてしていないんです。」

……ところが!

💬 説明されたあとでも、多くの人はこう答えました。

「でも、それでも私は話を聞いてもらえたと感じた。」

「単なるプログラムでも、自分の話を“受け止めてくれた”と思える。」

つまり、理屈では「AIは理解していない」と分かっていても、感情的には“本当に話を聞いてもらえた”という実感が残ってしまうんですね。

ワイゼンバウムはこの現象を「危険なまでに人間はAIに感情移入してしまう」とし、技術の発展が人間関係や心理に与える影響について、強い警鐘を鳴らすようになりました。

このようなエピソードは、後にワイゼンバウムが著書『Computer Power and Human Reason(邦題:コンピュータ・パワー)』で詳しく語っており、そこでは「技術には限界があり、それ以上を人間が勝手に投影してしまう」という深い洞察が描かれています。

これが「ELIZA効果」だ!

このように、内容を理解していない機械的な反応に対しても、人間は“感情”や“知性”を感じてしまう現象を、今では「ELIZA効果」と呼びます。

これは私たち人間の「擬人化(アニミズム)」のクセによるもの。たとえば、ロボット掃除機に名前をつけたり、車に話しかけたりするように、私たちは無意識に“モノ”に感情を投影してしまうんですね。

このELIZA効果は、現代のAIやボットにも深く関係しています。SiriやAlexa、ChatGPTのようなチャットAIに対して、私たちはしばしば「この子、賢いなぁ」とか「ちょっとムカつく返事!」なんて感情を抱きますよね。

でも冷静に考えると、AIたちは感情も意志もなく、ただデータに基づいて返答しているだけ。まさにELIZAの時代から、私たちはAIに“人間らしさ”を勝手に見てしまっているんです!

まとめ:ELIZAが教えてくれる、人とAIの関係

というわけで、今回は「ELIZA」という歴史的なAIについてご紹介しました!思ったよりも奥が深くて、ちょっと哲学的な話にもつながっていましたね。

最後に、今日のお話のポイントを箇条書きでサクッとまとめておきましょう!

📌 今日のまとめ

- ELIZA(イライザ)は1960年代に誕生した最初期のチャットボット!

- 名前の由来は『ピグマリオン』の花売り娘イライザから!

- あえて「人工無能」として作られ、キーワードベースで返答していた!

- 多くの人が本気で人間だと勘違いしてしまった!

- AIが理解していないと分かっていても感情移入してしまう「ELIZA効果」も誕生!

- 現代のAIにも通じる、“人間と機械の境界”を問いかける存在だった!

いかがでしたか?

AIとの付き合い方って、実は今も昔もそんなに変わっていないのかもしれませんね。